Gracias al conjunto de trabajo por parte de investigadores de Apple, han publicado avances sobre un nuevo método para entrenar modelos de lenguaje grandes integrando texto e información a la perfección. De acuerdo con el artículo de investigación publicado, se muestra un nuevo enfoque para crear sistemas de inteligencia artificial más inteligentes y flexibles. El nuevo modelo al que han llamado “MM1” es un nuevo estándar en la capacidad de la IA para realizar algunas tareas como el subtitulado en imágenes, respuestas visuales a preguntas y hasta visualización natural. Esto viene después de una nueva adquisición de Apple en materia de la propia IA.

Ya no es un secreto a voces, Apple está trabajando de lleno en IA

Publicado por primera vez por VentureBeat, esta investigación es una “combinación cuidadosa de diferentes tipos de datos de entrenamiento y arquitecturas de modelos” que pueden conducir al rendimiento de auténtica vanguardia en puntos de referencia de IA.

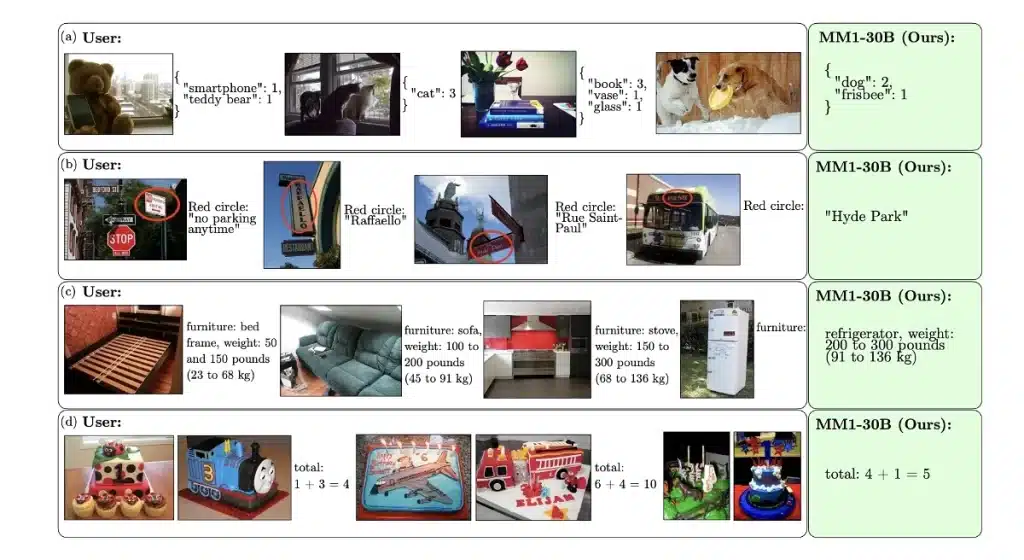

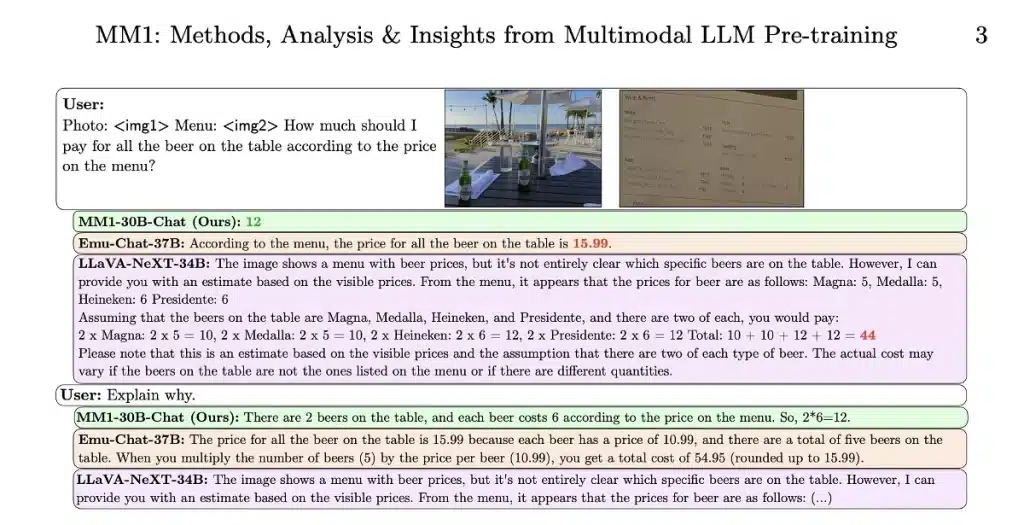

En este trabajo analizamos la construcción de modelos de lenguaje gran multimodal (MLLM) de alto rendimiento. Estudiamos la importancia de varios componentes de arquitectura y opciones de datos.

El modelo MM1 es “una familia de modelos multimodales” de última generación con grandes propiedades atractivas. Dentro de ellas resalta un “aprendizaje en contexto mejorado” y un “razonamiento de múltiples imágenes”. La nueva familia de modelos tiene un rendimiento increíble y competitivo dentro de una amplia gama de puntos de referencia.

Noticias difíciles de digerir en papel pero pronto se verán en la práctica

Es difícil comprender en su totalidad en lo que están trabajando los investigadores de Apple, sin embargo, podemos resumirlo en que están combinando diferentes tipos de datos y arquitecturas de modelos. La IA en cuestión tendrá que generar lenguaje basado en una combinación de señales que pueden ser tanto visuales como lingüisticas. Puede funcionar para la interpretación de imágenes o vídeos, responder a interrogantes de diferentes elementos que se aprecien en pantalla, etc.

Los de Cupertino no se quieren quedar atrás en cuanto a la competencia de inteligencia artificial, una tendencia que se ha ido expandiendo desde el año pasado y que se está materializando en dispositivos de la competencia. Recién Apple está conversando con Google para obtener licencias de Gemini para las funciones nuevas de iOS 18 que se podrán utilizar en el iPhone.